-

关于我们+

-

产品与服务+

-

解决方案+

-

客户案例+

-

AI创新中心+

-

投资者关系+

-

资源中心+

-

联系我们+

-

申请演示+

申请演示-

关于我们+

产品与服务+

解决方案+

客户案例+

AI创新中心+

投资者关系+

资源中心+

联系我们+

申请演示+

申请演示-

What

不仅要做出模型预测,还要给出模型产生预测结果的理由。知其然更要知其所以然

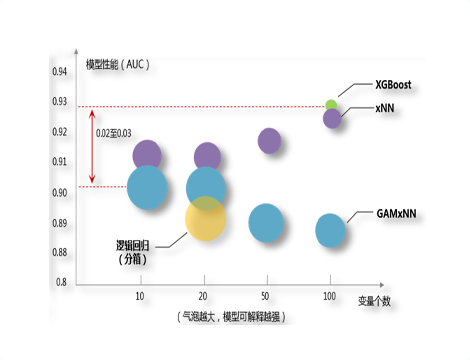

可解释机器学习(Intepretable Machine Learning,缩写为IML)的核心思想在于选择模型时,预测精度和可解释性并重,并尽量找到二者之间的最佳平衡

Backdrop

银行业的分析模型越来越多,所用算法也复杂多样

为了追求更高的模型精度,各种集成模型(如随机森林、XGBoost)和深层网络模型(如CNN、RNN、LSTM)成为热点算法,但由于模型过于复杂,这些算法已经成为无法理解的黑箱,业务上难以应用。

Innovation

兼顾模型的准确性和可解释性

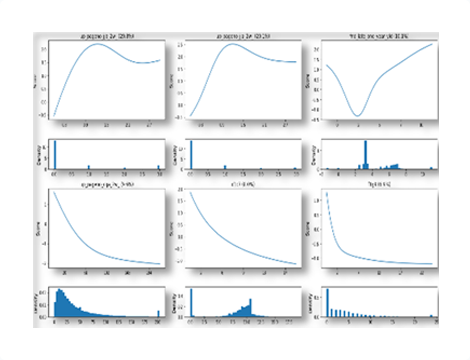

内在可解释(Intrinsic Interpretability)通过改良模型结构,增强模型灵活表征能力,提升模型的预测精度,如GAMxNN、RuleFit、Falling Rule List

事后可解释(Post-hoc Interpretability):保持复杂模型精度不变,通过事后的归因解析及可视化来获得模型的部分可解释性,如:LIME、SHAP

Value

在某银行的基金推荐点击预测项目中与XGBoost算法精度相当,特征变量从100个大幅缩减为10个,同时能够可视化展示这些特征带来的量化影响显著提高了业务上的可用性

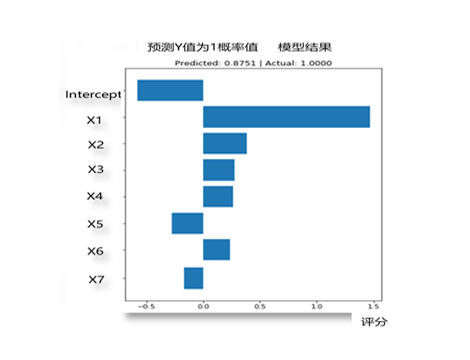

总体可解释性有助于业务人员理解模型的重要特征个体可解释性便于客户画像,进行个性化精准营销

可翻译分析模型

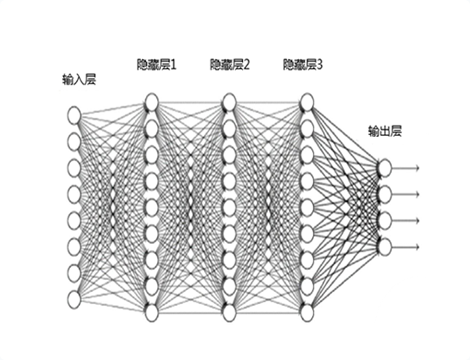

复杂的深层神经网络黑箱

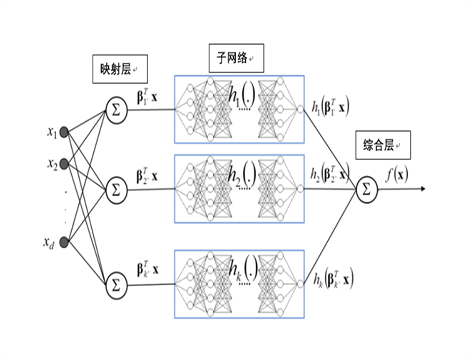

xNN

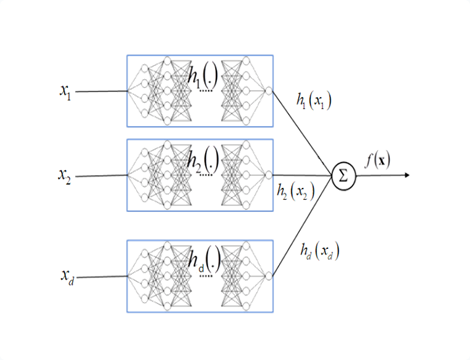

GAMxNN

多种算法的实际应用

模型性能与特征数量对比

总体可解释性

个体可解释性